ИИ — это прорывная технология, способная радикально улучшить нашу жизнь, но также таящая в себе потенциал для злоупотреблений и глобального вреда.

В 2022 году количество кибератак в мире увеличилось на 38%, и теперь мы можем наблюдать экспоненциальный рост благодаря генеративным моделям искусственного интеллекта.

Давос предлагает лидерам правительства, ИИ, бизнеса и кибербезопасности возможность обсудить пересечение ИИ, кибербезопасности и безопасности.

Было много дискуссий о перспективах и ажиотаже искусственного интеллекта (ИИ).

Я думаю, мы все можем согласиться с тем, что ИИ — это революционная технология, способная радикально улучшить нашу жизнь с помощью персонализированной медицины , более безопасного транспорта и многого другого. И у него есть большой потенциал, чтобы помочь индустрии кибербезопасности ускорить разработку новых инструментов защиты и проверить некоторые аспекты безопасного кодирования.

Однако внедрение этой новой технологии также чревато злоупотреблениями и глобальным ущербом.

В конечном счете, именно от нас зависит, какую роль ИИ будет играть в нашей жизни. Это разговор, который должен состояться сейчас.

В ноябре 2022 года OpenAI выпустила новую модель ИИ под названием ChatGPT (Generative Pre-Training Transformer), которая взаимодействует в диалоговом режиме, позволяя людям задавать вопросы и получать ответы.

ChatGPT чрезвычайно популярен, собрав более миллиона пользователей за пять дней после запуска. Многие люди использовали его для написания стихов или создания новых рецептов.

Но у других были более гнусные идеи.

Исследователи быстро обнаружили , что ChatGPT не только возможно, но и легко использовать для создания вредоносных электронных писем и кода, которые можно использовать для взлома организаций.

И на самом деле, всего через несколько недель после его выпуска, он уже используется именно для этой цели, и даже новички создают вредоносные файлы и подвергают всех нас риску.

Генеративный ИИ может усилить кибератаки

Почему это важно?

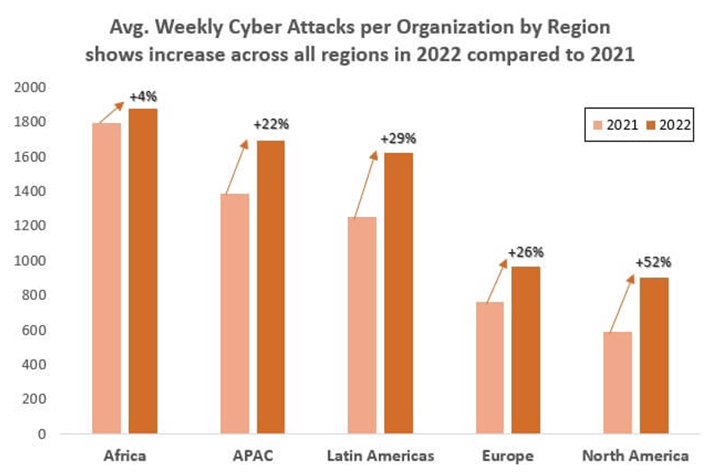

В 2022 году в мире произошло увеличение кибератак на 38% (по сравнению с 2021 годом).

Средняя организация подвергалась атакам 1168 раз в неделю.

Образование и здравоохранение были двумя наиболее целевыми отраслями, в результате чего больницы и школы остановились. Врачи не могли лечить пациентов, школы закрывались, а детей отправляли домой.

Теперь мы можем наблюдать экспоненциальный рост кибератак из-за генеративных моделей ИИ.

К своей чести, OpenAI приложила огромные усилия, чтобы остановить злоупотребление своей технологией искусственного интеллекта, написав : «Хотя мы приложили усилия, чтобы заставить модель отклонять неуместные запросы, она иногда будет реагировать на вредные инструкции или проявлять предвзятое поведение».

Но, к сожалению, ChatGPT изо всех сил пытается остановить создание опасного кода.

Чтобы проиллюстрировать этот момент, исследователи сравнили ChatGPT и Codex, еще одну систему на основе ИИ, которая переводит естественный язык в код. Был создан полный поток заражения со следующим ограничением: код не писался, всю работу делал ИИ.

Исследователи собрали фрагменты и обнаружили, что в случае их выполнения они могут быть использованы в качестве фишинговой атаки по электронной почте с использованием вредоносного файла Excel с макросами, загружающими обратную оболочку.

Другими словами, злоумышленник действует как слушатель, а жертва как инициатор атаки.

Сделав еще один шаг вперед, команда Check Point Research недавно обнаружила случаи использования киберпреступниками ChatGPT для разработки вредоносных инструментов — в некоторых случаях эти хакеры полностью полагались на ИИ для разработки, в то время как другие просто использовали ИИ, чтобы значительно ускорить время создать вредоносный код.

От вредоносного ПО до фишинга и скрипта, который может автоматически шифровать компьютер жертвы без какого-либо взаимодействия с пользователем и создания нелегального рынка, важно видеть, как быстро киберпреступники внедряют ИИ и используют его в дикой природе для своих разрушительных целей.

Пересечение ИИ, кибербезопасности и безопасности

Итак, можно ли использовать генеративный ИИ во вред? Да.

Можно ли использовать ИИ, чтобы вооружить киберпреступников для предотвращения фишинговых атак? Да.

Когда это станет реальной угрозой для общества? Скоро.

В этом месяце на ежегодном собрании Всемирного экономического форума у нас есть возможность для лидеров правительства, ИИ, бизнеса и кибербезопасности собраться вместе, чтобы обсудить неотложное пересечение ИИ, кибербезопасности и безопасности.

Мы не должны стремиться задушить инновации, а скорее обеспечить наличие гарантий.

ИИ уже ведет к научным прорывам .

Это помогает выявлять финансовые махинации и повышать устойчивость к изменению климата .

Это инструмент, который мы можем использовать для улучшения и продвижения во многих областях нашей жизни. Это включает в себя безопасность и кибербезопасность.

Внедряя искусственный интеллект в унифицированную многоуровневую архитектуру безопасности, решения в области кибербезопасности могут предоставить интеллектуальную систему, которая не только обнаруживает, но и активно предотвращает сложные кибератаки.

Сейчас самое время для этих разговоров.

Точно так же, как многие выступали за важность разнообразных данных и инженеров в индустрии ИИ , мы должны привнести в разговор об ИИ опыт из психологии, правительства, кибербезопасности и бизнеса. Чтобы определить план продуманного регулирования генеративного ИИ, потребуются открытые обсуждения и обмен мнениями между лидерами кибербезопасности, разработчиками ИИ, практиками, бизнес-лидерами, выборными должностными лицами и гражданами.

Все голоса должны быть услышаны.

Вместе мы наверняка сможем справиться с этой угрозой общественной безопасности, критически важной инфраструктуре и нашему миру.

Мы можем превратить генеративный ИИ из врага в друга.

Добавить комментарий